RTX 4080이 A100 40GB보다 일반적인 게임 및 그래픽 처리에서는 더 높은 성능을 보일 수 있지만, AI/딥러닝, 고성능 컴퓨팅(HPC) 작업에서는 A100 40GB가 훨씬 더 뛰어납니다.

4080 vs. A100 40GB 비교 (FP32 기준)

- FP32 성능이 더 높음 (4080: 48.7 TFLOPs vs. A100: 19.5 TFLOPs)

- → 일반적인 단정밀도(FP32) 연산에서는 4080이 더 빠름.

- 더 높은 클럭 속도 및 최신 공정 사용

- → 게이밍 및 일부 그래픽 워크로드에서 더 빠른 성능 제공.

- 비용 대비 성능 (4080: $1,199 vs. A100: $13,000+)

- → 가격이 훨씬 저렴하여 일반 사용자에게 접근성이 높음.

A100 40GB가 4080보다 훨씬 더 뛰어난 점

- Tensor Core 활용 (AI/딥러닝 특화)

- A100: 156 TFLOPs (TF32 연산) 지원

- RTX 4080은 AI 연산 최적화된 Tensor Core 성능이 부족함

- → AI 훈련/추론에서는 A100이 훨씬 더 강력함.

- HBM 메모리로 대용량 데이터 처리 가능

- A100: 40GB HBM2e, 1,555GB/s 대역폭

- 4080: 16GB GDDR6X, 736GB/s 대역폭

- → AI 모델 훈련 및 HPC 작업에서는 A100이 압도적으로 유리.

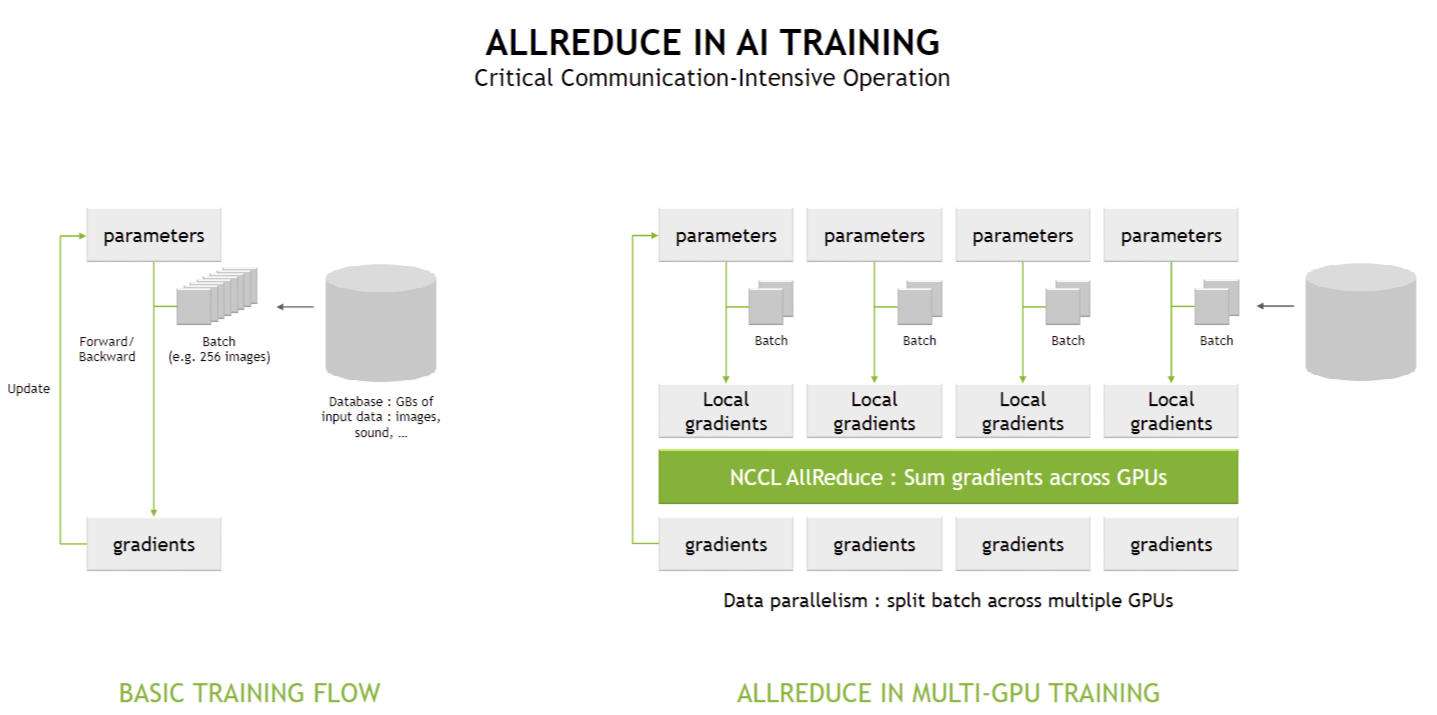

- NVLink 및 PCIe 확장성

- A100은 NVLink 지원으로 여러 GPU를 빠르게 연결 가능

- RTX 4080은 NVLink 미지원, PCIe만 가능

- → 대규모 클러스터 구축 시 A100이 필수.

- 데이터센터 및 서버 최적화

- A100은 데이터센터 및 HPC 환경에 최적화

- 4080은 소비자용(게이밍/콘텐츠 제작) 최적화

- → 지속적인 AI 훈련 및 대규모 병렬 연산에 A100이 필수.

결론: AI & HPC vs. 게이밍 & 크리에이티브

- AI 연구 / 딥러닝 / HPC / 데이터센터 → A100 40GB 선택

게임 / 크리에이터 / 일부 AI (Stable Diffusion 등) → RTX 4080 선택

즉, RTX 4080이 단순 연산 속도(FP32)에서는 A100보다 빠를 수 있지만, AI/딥러닝/HPC 용도로는 A100이 절대적으로 더 강력한 GPU입니다.

이 질문은 병렬 처리와 연산 자원의 활용에 관한 것입니다. 정답은 워크로드의 병렬화 가능성에 따라 달라집니다.

1️⃣ 두 가지 시나리오 비교

시나리오총 연산량총 연산 성능연산 방식| A: 1개의 모델, 100 PFLOPs | 동일 | 100 PFLOPs | 단일 모델 |

| B: 10개의 모델, 각 10 PFLOPs | 동일 | 10 × 10 PFLOPs = 100 PFLOPs | 독립적 모델 10개 |

동일한 연산량(예: 1,000 PFLOP)이 주어졌을 때

- 단일 모델(100 PFLOPs)

→ 1,000 PFLOP / 100 PFLOPs = 10초 - 10개의 모델(각 10 PFLOPs)

→ 1,000 PFLOP / (10 × 10 PFLOPs) = 10초

즉, 단순 계산으로는 실행 시간이 동일합니다.

2️⃣ 그러나 현실적인 차이점

A: 1개의 모델이 100 PFLOPs를 사용 (큰 GPU 클러스터에서 실행)

- 메모리 병목 가능성: 대규모 모델이 GPU의 HBM 메모리 및 대역폭을 초과할 수 있음

- 병렬화 한계: 단일 모델이 100 PFLOPs를 완전히 활용할 수 있는지 불확실함 (GPU 활용도 ↓)

- 싱글 노드 한계: 특정 하드웨어에서 실행될 경우, 분산 학습이 어려울 수도 있음

B: 10개의 모델이 각 10 PFLOPs 사용 (여러 GPU에서 개별 실행)

- 모델 간 독립적 실행 가능: 다중 GPU 노드에서 실행하면 개별 모델이 자원을 효율적으로 활용 가능

- GPU 활용률 최적화: 한 개의 모델이 전체 자원을 활용하는 것보다, 다중 모델이 각 GPU에 분산되면 더 효율적

- 데이터 병렬성 유지 가능: 각 모델이 개별 데이터셋을 학습하면 더 효과적으로 처리 가능

3️⃣ 결론: 어느 것이 더 빠를까?

✔ 이론적으로 두 경우 모두 같은 시간이 걸릴 수 있음.

✔ 그러나 현실에서는 10개의 모델(각 10 PFLOPs)이 더 효율적으로 실행될 가능성이 높음.

✔ 단일 모델이 100 PFLOPs를 완전히 활용할 수 없다면 오히려 더 느려질 수도 있음.

즉, 병렬화 가능성과 하드웨어 자원 활용도가 중요한 요소이며, 현실적으로는 10개의 독립적 모델이 더 빠를 가능성이 높습니다.

1. RTX 4080

특징

장점

단점

- A100, H100에 비해 AI 및 HPC 워크로드에서 성능이 낮음

- 메모리 용량이 상대적으로 적음

2. A100 40GB

특징

장점

- 높은 메모리 대역폭으로 빠른 데이터 처리

- AI 및 HPC 워크로드에 최적화된 성능

단점

- H100에 비해 낮은 메모리 용량

- 최신 Hopper 아키텍처의 이점을 누리지 못함

3. H100 80GB

특징

장점

단점

- 높은 가격

- 높은 전력 소비

주요 차이점

- 용도:

- RTX 4080: 주로 게이밍 및 그래픽 작업

- A100, H100: AI, 머신러닝, HPC 워크로드

- 아키텍처:

- RTX 4080: Ampere

- A100: Ampere

- H100: Hopper (최신)

- 메모리:

- RTX 4080: 16GB GDDR6X

- A100: 40GB HBM2

- H100: 80GB HBM2e

- 성능:

- H100 > A100 > RTX 4080 (AI 및 HPC 워크로드 기준)

결론

각 GPU는 특정 용도에 최적화되어 있습니다. RTX 4080은 고성능 게이밍과 그래픽 작업에 적합하며, A100과 H100은 AI 및 HPC 워크로드에 특화되어 있습니다. H100은 최신 아키텍처와 높은 메모리 용량으로 최고의 성능을 제공하지만, 가격과 전력 소비가 높습니다. 사용 목적과 예산에 따라 적절한 GPU를 선택해야 합니다.

'AI > NVIDIA' 카테고리의 다른 글

| ARM 및 RISC-V 기반 슈퍼컴퓨터 설계 및 DGX H100 비교 보고서 (0) | 2025.02.24 |

|---|---|

| NVLink Evolution and GPU Ecosystem: From Version 1.0 to 6.0 (1) | 2025.02.24 |

| DGX H100 SUPERPOD: NVLINK SWITCH 상세 설명 (0) | 2025.02.24 |

| DGX H100: Data-Network Configuration 상세 분석 (0) | 2025.02.24 |

| DGX H100 SERVER 상세 분석 (0) | 2025.02.24 |