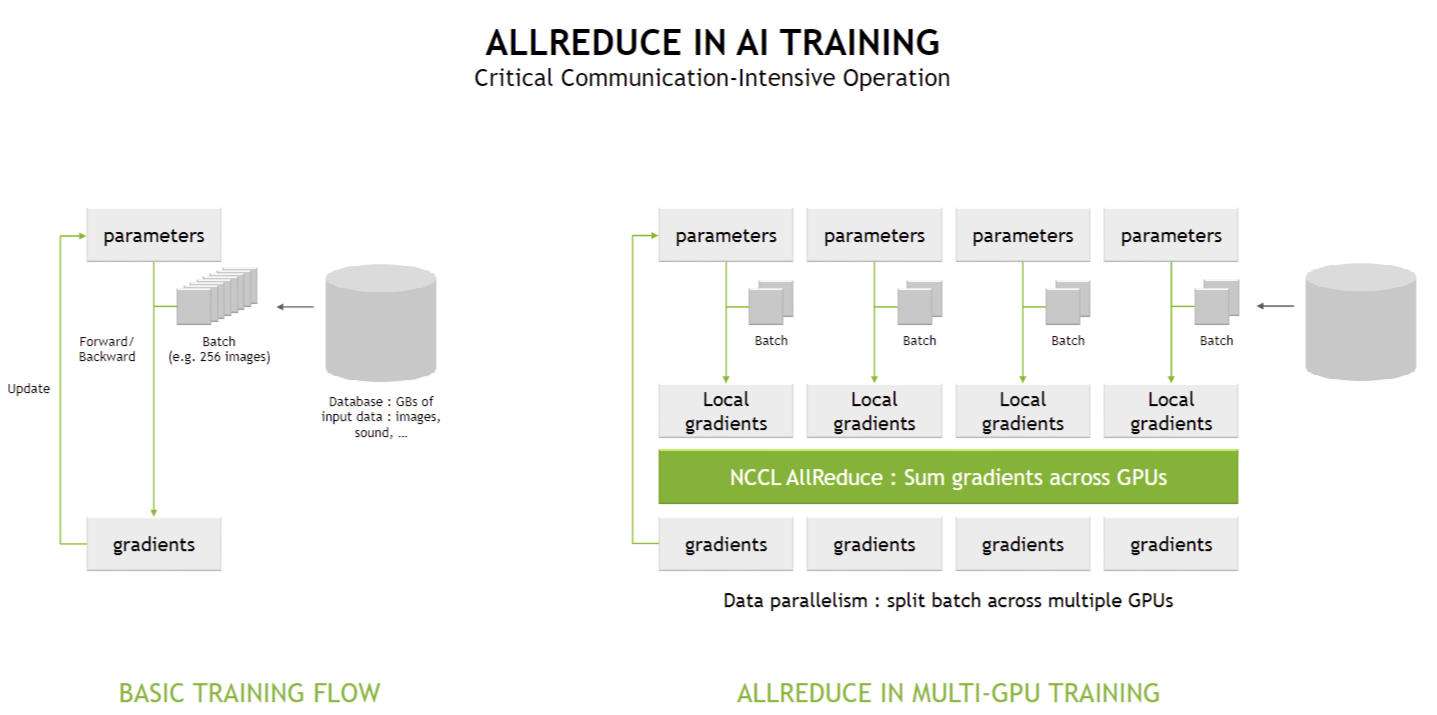

딥러닝 모델 학습에서 AllReduce 연산이 어떻게 사용되는지를 설명하는 다이어그램입니다. 특히 멀티-GPU 환경에서 데이터 병렬 학습을 최적화하는 방법을 보여줍니다.

1. 기본적인 AI 모델 학습 흐름 (Basic Training Flow)

✅ (1) 학습 데이터 로딩

- 대량의 입력 데이터(이미지, 오디오, 텍스트 등)를 데이터베이스에서 가져옴

- 미니배치(batch) 단위로 나누어 GPU에 전달 (예: 256개의 이미지)

✅ (2) 순전파 (Forward Pass)

- 신경망의 각 레이어를 거쳐 데이터가 변환되면서 예측값이 생성됨

- 모델의 현재 파라미터(parameters)를 사용하여 출력을 계산

✅ (3) 역전파 (Backward Pass)

- 예측값과 정답 간의 차이(오차)를 바탕으로 그래디언트(gradients, 기울기)를 계산

- 그래디언트는 각 레이어의 가중치 업데이트에 사용됨

✅ (4) 파라미터 업데이트 (Parameter Update)

- 그래디언트를 사용하여 모델의 가중치(파라미터)를 업데이트

- 업데이트된 파라미터는 다음 배치 학습에 사용됨

👉 기본적인 AI 학습 흐름에서는 단일 GPU에서 연산이 이루어지므로, GPU 간의 데이터 동기화 과정이 필요하지 않음

2. 멀티-GPU 학습에서의 AllReduce (AllReduce in Multi-GPU Training)

멀티-GPU 환경에서는 데이터 병렬화(Data Parallelism)를 사용하여 각 GPU가 서로 다른 배치를 처리하지만, 동기화를 위해 AllReduce 연산이 필수적입니다.

✅ (1) 데이터 병렬화 (Data Parallelism)

- 입력 배치를 여러 개로 나누어 각 GPU에 분배

- 예: 256개의 이미지를 4개의 GPU에 나누어 처리 (각 GPU당 64개)

- 모든 GPU가 같은 신경망을 복사하여 동일한 모델을 학습하지만, 각 GPU는 서로 다른 데이터 배치를 처리함

✅ (2) 로컬 그래디언트 계산 (Local Gradients)

- 각 GPU는 자신의 배치에 대해 순전파(Forward)와 역전파(Backward)를 수행

- 각 GPU에서 개별적으로 그래디언트를 계산하여 가중치 업데이트 준비

✅ (3) AllReduce 수행: 그래디언트 공유 및 합산

- NCCL (NVIDIA Collective Communications Library) AllReduce 연산 수행

- 모든 GPU가 계산한 로컬 그래디언트(Local Gradients)를 서로 공유하고 평균을 구함

- 이렇게 하면 모든 GPU가 동일한 파라미터 업데이트 값을 사용하게 됨

- AllReduce는 각 GPU의 그래디언트를 더하고 평균을 구하는 과정

✅ (4) 업데이트된 그래디언트를 모든 GPU에 동기화

- 각 GPU가 동일한 업데이트된 그래디언트를 적용하여 모델을 동기화

- 이후 다음 배치를 학습할 때 모든 GPU가 동일한 모델을 사용

3. AllReduce가 필요한 이유

멀티-GPU 학습에서는 GPU 간 동기화가 없으면 각 GPU가 서로 다른 모델을 학습하게 되어 성능이 저하됩니다.

AllReduce는 다음과 같은 역할을 수행합니다:

- GPU 간 그래디언트를 공유하여 모델의 일관성을 유지

- 그래디언트를 합산 후 평균을 내어 모든 GPU가 같은 파라미터 업데이트 적용

- 병렬 처리를 하면서도 하나의 모델처럼 학습을 진행할 수 있도록 보장

- AI 훈련 속도 향상 및 메모리 사용 최적화

4. 결론

- 기본적인 AI 훈련 흐름에서는 단일 GPU에서 모델을 학습하지만, 멀티-GPU 학습에서는 AllReduce를 활용하여 그래디언트를 동기화해야 함

- NCCL AllReduce를 통해 각 GPU의 그래디언트를 합산하고 공유하여 모델 업데이트를 일관되게 유지

- AllReduce는 AI 훈련에서 가장 중요한 병렬 연산 중 하나이며, 특히 대규모 AI 모델 학습에서 필수적인 요소

즉, 멀티-GPU AI 학습에서는 AllReduce가 GPU 간 데이터 동기화의 핵심 역할을 수행하며, 이를 통해 학습 속도를 최적화하고 정확도를 보장합니다. 🚀

AllReduce는 NVIDIA 전용 명령어가 아니라, 분산 컴퓨팅 및 병렬 처리에서 널리 사용되는 개념입니다.

NVIDIA는 자사의 GPU 간 통신 라이브러리(NCCL, NVLink, NVSwitch 등)를 활용하여 효율적인 AllReduce 연산을 구현하지만, AllReduce 자체는 NVIDIA 전용 개념이 아닙니다.

1. AllReduce란?

AllReduce는 분산 병렬 컴퓨팅에서 여러 프로세서(또는 GPU)가 계산한 데이터를 합산(또는 다른 연산 수행)한 후, 모든 프로세서에 결과를 공유하는 연산입니다.

즉, 각 장치가 개별적으로 계산한 값을 합치고, 최종 결과를 모든 장치가 동일하게 가지도록 동기화하는 방식입니다.

✅ AllReduce 연산 공식

- 여기서 x1,x2,...,xnx_1, x_2, ..., x_n은 각 GPU가 계산한 값

- 결과는 모든 GPU에 동일하게 전달됨

2. AllReduce는 어디에서 사용될까?

AllReduce는 병렬 컴퓨팅과 분산 학습을 최적화하는 데 중요한 연산입니다.

(1) 딥러닝 / AI 모델 학습

- 데이터 병렬 처리 (Data Parallelism)에서 각 GPU가 계산한 그래디언트를 동기화하는 데 사용

- PyTorch, TensorFlow, JAX 등에서 AllReduce를 통해 멀티-GPU 학습을 수행

- NVIDIA의 NCCL (NVIDIA Collective Communications Library)이 AllReduce를 가속화

(2) MPI (Message Passing Interface) 기반 슈퍼컴퓨팅

- HPC (High-Performance Computing) 환경에서도 AllReduce가 중요한 연산

- MPI(Message Passing Interface)에서도 AllReduce를 통해 CPU 또는 GPU 간 데이터를 동기화

- OpenMPI, MPICH, Intel MPI 등에서 AllReduce 연산을 제공

(3) 데이터센터 및 클라우드 분산 연산

- 클라우드 환경에서 대규모 데이터 분석 및 AI 모델 동기화

- Amazon AWS, Google Cloud, Microsoft Azure의 AI 분산 학습 시스템에서 활용

- Horovod (Uber에서 개발한 분산 학습 라이브러리)도 AllReduce를 최적화하여 멀티-GPU 및 멀티노드 학습 수행

3. NVIDIA에서 AllReduce를 가속화하는 방법

NVIDIA는 GPU 간 통신을 최적화하여 AllReduce를 빠르게 수행할 수 있도록 여러 기술을 활용합니다.

기술설명

| NCCL (NVIDIA Collective Communications Library) | GPU 간 빠른 AllReduce 연산을 위한 라이브러리 |

| NVLink | PCIe보다 빠른 GPU 간 직접 데이터 전송 |

| NVSwitch | 대규모 GPU 클러스터에서 AllReduce 성능 최적화 |

| SHARP (Scalable Hierarchical Aggregation and Reduction Protocol) | NVSwitch에 내장된 AllReduce 가속기 |

즉, NVIDIA는 AllReduce 연산을 최적화하는 강력한 하드웨어와 소프트웨어를 제공하지만, AllReduce 자체는 NVIDIA에만 국한된 개념이 아닙니다.

4. 결론

- AllReduce는 NVIDIA 전용 명령어가 아니라, 분산 컴퓨팅에서 널리 사용되는 병렬 연산 기법

- NVIDIA는 NCCL, NVLink, NVSwitch 등을 활용하여 AllReduce 성능을 극대화

- PyTorch, TensorFlow, MPI 등의 프레임워크에서도 AllReduce를 사용하여 병렬 처리를 최적화

- 슈퍼컴퓨터, AI 학습, 데이터센터 등에서 AllReduce는 필수적인 연산

👉 AllReduce는 분산 학습과 병렬 연산에서 중요한 개념이며, NVIDIA뿐만 아니라 여러 컴퓨팅 환경에서 사용됩니다. 🚀

'AI > NVIDIA' 카테고리의 다른 글

| NVLink SHARP Acceleration: NVLink 기반의 SHARP 가속화 (0) | 2025.02.23 |

|---|---|

| 전통적인 AllReduce 계산 (Traditional AllReduce Calculation) (0) | 2025.02.23 |

| NVLink 4 NVSwitch 칩 아키텍처 상세 설명 (0) | 2025.02.23 |

| NVLink 4 기반의 NVSwitch의 새로운 기능 (0) | 2025.02.23 |

| NVLink 기반 서버(DGX) 세대별 발전 과정 (0) | 2025.02.23 |