ISP 아키텍처의 변천사 (2000년 ~ 현재)

스마트폰과 디지털 카메라의 발전과 함께 이미지 신호 처리기(ISP, Image Signal Processor) 기술도 2000년대부터 현재까지 비약적으로 향상되었습니다. 초기에는 저화소 이미지 처리를 중심으로 단순한 파이프라인을 갖고 있었지만, 모바일 촬영 수요가 증가하면서 ISP 아키텍처는 성능과 기능 면에서 큰 변화를 겪었습니다. 아래에서는 2000년대 초반부터 2020년대 현재까지 ISP 아키텍처의 시대별 특징과 성능 향상 요소를 살펴보고, Qualcomm, Apple, Samsung 세 업체의 ISP 발전 과정을 비교한 후, 최신 ISP의 내부 구성 블록과 알고리즘에 대해 상세히 설명합니다.

2000년대 초반: 초기 ISP 통합과 저화소 처리

디지털 카메라가 보급되기 시작한 2000년대 초반에는 주로 저화소 센서의 기본 처리에 초점을 둔 ISP 기술이 등장했습니다. 초창기 휴대폰 카메라의 이미지 처리는 전용 하드웨어 없이 DSP나 CPU에 의해 소프트웨어적으로 수행되곤 했습니다. 퀄컴(Qualcomm)은 2002년 모바일 칩셋 내부에 세계 최초로 카메라용 ISP를 통합하여 당시 1.3메가픽셀(MP) 센서 출력을 DSP 기반으로 처리했고, 이어 2004년경에는 4MP까지 지원하는 하드웨어 ISP(MSM6550)를 선보였습니다. 이는 카메라 모듈을 별도 프로세서가 아닌 메인 칩셋에서 직접 처리하는 통합 설계의 시작이었습니다. 당시 ISP는 디지털 카메라 분야에서도 캐논의 DIGIC, 니콘의 Expeed와 같이 별도 칩 형태로 존재했으나, 모바일 분야에서는 TI OMAP 등 일부 애플리케이션 프로세서에 이미지 처리 기능이 점진적으로 포함되기 시작했습니다. 예를 들어 TI OMAP 3430 칩은 2009년경 최대 12MP 카메라를 지원하는 ISP를 내장하여 노키아 등의 스마트폰에 사용되었습니다.

이 시기의 ISP 아키텍처는 비교적 단순한 픽셀 처리 파이프라인으로, 센서로부터 받은 베이어(Bayer) 패턴의 저해상도 영상을 보정하고 JPEG로 압축하는 기본 기능에 충실했습니다. 성능적으로도 현재와 비교해 매우 낮은 처리량(throughput)을 가졌지만, 휴대폰에 카메라를 탑재하는 개념을 실현하고 ‘항상 들고 다니는 카메라’ 시대를 여는 데 기여했습니다. 2000년대 중반까지의 ISP 발전 핵심은 통합과 비용 절감이었으며, 휴대폰 내부에 ISP를 넣음으로써 별도 카메라 프로세서 비용을 줄이고자 했습니다.

2010년대: 모바일 ISP의 등장과 발전

2010년대에 접어들면서 스마트폰 카메라 성능 경쟁이 본격화되고, 이에 따라 ISP 아키텍처도 빠르게 발전했습니다. 이 시기 주요 변화는 화소 수와 영상 해상도의 급증, 그리고 멀티카메라 지원입니다. 2010년 전후의 스마트폰들은 58MP 카메라와 720p1080p 동영상 촬영을 지원하기 시작했고, 이를 처리하기 위해 ISP는 점차 전용 하드웨어 가속기와 병렬 처리 구조를 갖추게 되었습니다.

특히 퀄컴 Snapdragon 시리즈와 삼성 Exynos, 애플 A시리즈 SoC 모두 이 시기에 ISP 성능을 대폭 향상시켰습니다. 2013년 퀄컴 Snapdragon 800은 듀얼 ISP 구조를 도입하여 동시 듀얼 카메라 처리와 스테레오 3D 촬영을 지원했고, 최대 21MP 센서 및 4K 비디오 촬영까지 가능해졌습니다. 이어 2014~2015년 Snapdragon 810 등에서는 듀얼 ISP로 각각 600MHz 클럭에서 동작하여 결합 시 초당 1.2 기가픽셀에 달하는 처리량을 달성, 고해상도 제로 셔터랙(ZSL) 연사와 실시간 고화질 처리 기능을 구현했습니다. 이러한 듀얼 ISP 아키텍처는 한 쪽 ISP로 고해상도 사진을 처리하면서 동시에 다른 ISP로 4K 동영상을 촬영한다거나, 또는 두 개의 카메라로 광각+망원 등의 듀얼 카메라 기능을 구현할 수 있게 해 주었습니다.

스마트폰 제조사들이 앞다투어 듀얼 카메라를 도입한 2016~2017년에는, ISP가 실시간 심도 효과(보케)나 즉각적인 오토포커스 등을 지원하도록 발전했습니다. 예컨대, 듀얼 카메라로 두 이미지를 동시 처리하여 피사체와 배경을 분리하는 연산이 ISP 하드웨어로 가속되면서 인물사진 모드와 같은 컴퓨테이셔널 포토그래피 기능이 대중화되었습니다. 또한 이 시기 노이즈 감소와 HDR 합성 등 멀티프레임 기반의 알고리즘도 도입되어, 어두운 환경에서 연속 촬영한 여러 프레임을 합쳐 노이즈를 줄이고, 명부와 암부가 극단적인 장면을 HDR로 합성하는 기능이 발전했습니다.

애플(Apple)은 2018년 아이폰에 스마트 HDR 기능을 넣어 여러 장의 이미지를 합성함으로써 뛰어난 다이내믹 레인지 표현을 보여주었고, 구글(Google)은 HDR+로 소프트웨어 기반 멀티프레임 합성을 선보이는 등, 2010년대 후반에는 ISP + 소프트웨어의 조합으로 사진 품질을 향상시키는 컴퓨테이셔널 포토그래피가 핵심 기술로 자리잡았습니다.

한편 삼성의 ISP 발전도 이 시기 두드러져, 2017년 Exynos 8895 칩은 전후면 각 28MP까지 카메라를 지원하는 향상된 ISP를 탑재했고, 듀얼 카메라 구성(예: 28MP+16MP 등)을 지원하도록 업그레이드되었습니다. 이는 동년의 퀄컴 Snapdragon 835(최대 32MP 단일, 듀얼 카메라 지원)와 견줄만한 수준으로, 삼성 역시 듀얼 ISP 설계를 통해 다중 카메라 센서 입력을 병렬로 처리할 수 있게 되었습니다. 2010년대 후반의 ISP는 보정과 필터 단계에서도 머신러닝 기법이 실험적으로 도입되기 시작했는데, 예를 들어 화웨이는 Kirin 970(2017년)에서 별도 NPU를 활용한 AI 기반 사진 개선을 내세웠고, 애플도 A11 Bionic2017년에서 자체 ISP와 함께 뉴럴 엔진을 도입하여 사진 신호 처리 일부에 활용하기 시작했습니다.

요약하면 2010년대의 ISP 아키텍처 발전을 이끈 요소는 (1) 센서 해상도의 증가, (2) 동영상 해상도 향상(1080p→4K), (3) 멀티카메라 및 듀얼-ISP 구조, (4) 실시간 처리 기능(ZSL, 빠른 AF 등), (5) 컴퓨테이셔널 포토그래피 기법(HDR, 심도합성)으로 정리될 수 있습니다. 이로써 스마트폰 카메라 품질이 전반적으로 비약적으로 향상되었으며, DSLR에 버금가는 기능들이 모바일에서 구현되기 시작했습니다.

2020년대 이후: 현대 ISP 아키텍처의 특징

2020년대의 최신 ISP 아키텍처는 이전 세대와 비교해 더욱 병렬처리 능력, AI 통합, 고속화가 두드러집니다. 퀄컴 Snapdragon 888(2020년 말 발표)부터는 모바일 SoC에 트리플 ISP 구조를 도입하여, 3개의 카메라 스트림을 동시 처리할 수 있게 되었습니다. 예를 들어, 초광각-광각-망원의 세 개 카메라에서 입력을 받아 끊김없이 부드럽게 줌을 전환하는 Smooth Zoom 기능은 각 카메라 센서를 별도 ISP 파이프라인에 연결하여 동시에 활성화함으로써 가능해졌습니다. Snapdragon 888의 Spectra 580 ISP는 최대 초당 2.7기가픽셀의 엄청난 처리능력을 제공하여, 120장의 1200만 화소 사진을 1초에 연속 촬영하거나 세 개의 4K HDR 영상을 동시 녹화하는 등 이전에는 불가능했던 동시처리를 구현했습니다. 또한 Snapdragon 888은 14비트 이미지 처리를 통해 더욱 풍부한 색상과 다이나믹레인지를 다룰 수 있었고, 후속인 Snapdragon 8 Gen1(2021년)에서는 18비트 ISP로 업그레이드되어 센서의 HDR 신호를 더욱 정밀하게 처리하도록 발전했습니다.

이 시기 ISP 발전의 핵심 기술 중 하나는 스태거드 HDR(Staggered HDR) 지원입니다. 최신 센서는 한 번의 촬영으로 서로 다른 노출 조건의 이미지를 빠르게 연속 출력할 수 있는데, 3개의 노출 프레임을 ISP에서 실시간으로 합성하여 HDR 영상을 만들어내는 기술이 상용화되었습니다. 예를 들어 Snapdragon 888은 세 노출의 프레임을 실시간 융합(fusion)하여 높은 다이내믹레인지의 영상 스트림을 출력하며, 이를 통해 스마트폰에서도 HDR 비디오를 실시간으로 기록할 수 있게 되었습니다. 애플도 2020년 A14 Bionic부터 Dolby Vision 수준의 HDR 비디오 녹화를 지원했고, 삼성 Exynos 역시 2021년 Exynos 2100에서 최대 4개 카메라를 동시에 구동하며 200MP 센서까지 연결할 수 있는 강력한 ISP를 내장했습니다. 현대 ISP는 이처럼 다중센서 병렬처리, 초고해상도 센서 지원, 실시간 HDR 합성을 큰 축으로 발전하고 있습니다.

또 다른 특징은 AI와 ISP의 밀접한 통합입니다. 최신 ISP는 단순한 하드웨어 처리기를 넘어 SoC 내 DSP/AI 가속기와 연동하여 이미지 품질을 향상시킵니다. 퀄컴은 Spectra ISP에서 “3A(AE/AF/AWB) AI 엔진”을 도입하여 자동초점, 자동노출, 자동화이트밸런스 성능을 머신러닝으로 향상시켰다고 발표했으며, 실제로 Snapdragon 888은 사람의 시선 데이터를 학습한 AI 기반 오토포커스 알고리즘을 통해 피사체에 한층 정확히 초점을 맞추는 기능을 제공합니다. 또한 장면을 세그멘테이션(segmentation)하여 하늘, 인물, 배경 등을 구분하고 각각에 다른 필터를 적용하는 등 장면별 최적화도 AI로 가능해졌습니다. 한편 애플은 딥퓨전(Deep Fusion) 기술을 통해 뉴럴 엔진으로 각 픽셀의 디테일을 보강하는 컴퓨테이셔널 사진을 도입했고, 삼성 역시 Scene Optimizer와 같은 AI 기능으로 촬영 장면에 맞춰 색감과 노이즈를 조정하고 있습니다. 이러한 AI 기술은 ISP 하드웨어와 결합되어 실시간으로 구동되며, 최신 스마트폰 카메라의 야간 모드, 인물 모드, 자동 장면 인식 등의 기능에 크게 기여하고 있습니다.

정리하면, 2020년대의 ISP 아키텍처는 멀티 ISP 병렬 구조, 고속·고정밀 처리(고비트 심도), 실시간 HDR 및 다중프레임 합성, AI와의 통합으로 요약될 수 있습니다. 아래 표는 각 시기별 ISP 발전을 간략히 정리한 것입니다:

| 2000년대 초반 | ~1-4 MP, 480p 영상 | 초기 ISP 통합 (DSP 기반 처리), 기본 보정 처리 | Qualcomm MSM6500 (2002)

TI OMAP 1710 (2005) 등 |

| 2010년대 초반 | ~5-12 MP, 1080p 영상 | 단일 ISP 하드웨어 가속, 화소 및 해상도 증가 | Apple A5 (2011) 8MP 지원 Qualcomm S4 (2012) 1080p 지원 |

| 2010년대 후반 | ~16-28 MP, 4K 영상 @30fps | 듀얼 ISP, 듀얼카메라 및 ZSL, HDR 합성 도입 | Snapdragon 800 (2013) 듀얼 ISP

Exynos 8895 (2017) 28MP 듀얼 |

| 2020년대 | 50-200+ MP, 8K 영상/ HDR 영상 | 트리플 ISP, 멀티센서 동시처리, AI 보조 3A 제어 | Snapdragon 888 (2020) 트리플 ISP

Exynos 2100 (2021) 200MP 지원 |

표: 시대별 ISP 아키텍처 발전 사례

Qualcomm, Apple, Samsung 주요 ISP 비교

이 절에서는 Qualcomm(퀄컴), Apple(애플), Samsung(삼성) 세 회사의 ISP 발전 과정을 살펴보고 각사의 하드웨어 구성과 특징, 이미지 처리 성능의 차별점을 비교합니다. 세 업체 모두 모바일 SoC에 통합된 ISP를 설계하지만, 출발 시점과 강점이 달라 발전 경로에 차이가 있습니다.

Qualcomm의 ISP 발전 (Snapdragon Spectra)

퀄컴은 모바일 ISP 분야의 선구자로, 일찍이 2000년대 초반부터 휴대폰용 통합 카메라 프로세서를 도입했습니다. 앞서 언급한 대로 2002년 MSM6500 칩에 1.3MP 처리를 지원하는 DSP 기반 ISP를 넣은 것을 시작으로, 2000년대 후반 Snapdragon 시리즈로 이어진 퀄컴의 ISP는 모바일 카메라 성능 향상을 주도했습니다.

Snapdragon SoC의 ISP는 세대를 거듭하며 성능이 크게 향상되었고, 2016년 이후 “Spectra”라는 브랜드명으로 불리기 시작했습니다. Spectra 180 ISP(스냅드래곤 820/821, 2016)는 이전 세대 대비 저조도 화질 개선과 하이브리드 오토포커스를 지원했고, Spectra 280 ISP(스냅드래곤 845, 2018)는 듀얼 ISP로 동시 처리량을 높이며 컴퓨터 비전 용도의 부속 기능(예: 능동형 깊이센싱)을 포함했습니다. 2019년 Snapdragon 855의 Spectra 380은 하드웨어 가속 컴퓨테이셔널 포토그래피 기능을 강화하여 4K HDR 영상 및 물체 분류 등의 처리를 실시간 지원했습니다.

가장 큰 도약은 앞서 설명한 2020년 말 Snapdragon 888(Spectra 580)에서 이뤄졌는데, 트리플 ISP 설계를 최초로 도입하여 각기 14비트 파이프라인을 통해 세 개 카메라 스트림을 병렬 처리하게 되었습니다. 이를 통해 최대 3개의 4K HDR 동영상 스트림 동시 녹화나 초당 2.7기가픽셀 이미지 처리가 가능해졌으며, 센서 1개 사용 시 최대 84MP에서 제로셔터랙(ZSL) 촬영을 지원하는 성능을 보여주었습니다. Spectra 580에는 또한 스태거드 HDR 센서 지원이 추가되어, 센서가 출력하는 다중 노출 프레임들을 ISP 내에서 바로 결합함으로써 실시간 HDR 합성이 가능해졌습니다. 이후 Snapdragon 8 1세대(Gen1)에서는 처리 파이프라인이 18비트로 향상되고 AI 엔진과의 연계로 목표 물체 추적, AI 노이즈 억제 등의 세부 기능이 추가되는 등 Qualcomm ISP는 최고 수준의 처리량과 다기능성을 갖추게 되었습니다.

Qualcomm ISP의 특징은 경쟁사 대비 이른 시기부터 듀얼/트리플 ISP 구조를 채택하여 동시 처리능력이 뛰어나다는 점입니다. 또한 Hexagon DSP와의 연계를 통해 얼굴인식, 영상보정 등 AI 기반 알고리즘을 ISP 파이프라인에 통합시키는 데 강점이 있습니다. 실제로 Snapdragon 888은 3A(자동초점, 노출, 화이트밸런스) 알고리즘에 AI를 도입하여, 사람의 시선 움직임을 학습한 딥러닝 자동초점으로 촬영 시 초점 정확도와 추적 성능을 높였습니다. 퀄컴은 이러한 ISP와 AI의 결합을 통해 사용자 개입 없이도 최적의 사진을 얻을 수 있는 Scene Detection, Autozoom(피사체 자동 확대) 등의 기능을 구현하고 있습니다.

Apple의 ISP 발전 (A시리즈 SoC)

애플은 아이폰용 A 시리즈 SoC에 커스텀 ISP를 통합하여 하드웨어와 소프트웨어를 최적화하는 전략을 취해왔습니다. 초창기 아이폰(2007~2010년)의 ISP 세부사항은 공개되지 않았으나, 2011년 A5 칩부터 800만 화소 카메라 지원을 위해 향상된 이미지 처리 엔진이 탑재되었습니다. 2013년 A7 칩(아이폰 5s)은 64비트 CPU와 함께 이미지 시그널 프로세서 개선으로 연사속도와 슬로모션 비디오(720p@120fps) 처리를 지원했고, 2015년 A9(아이폰 6s)에서는 1200만 화소와 4K 비디오에 대응하는 ISP 성능 향상이 이루어졌습니다.

애플이 공개적으로 ISP의 존재를 강조하기 시작한 것은 2017년 A11 Bionic부터입니다. 애플은 A11에 자체 설계 ISP를 넣었다고 소개하며, 저조도 자동초점 속도 개선, 새로운 멀티밴드 노이즈 감소 하드웨어를 통한 향상된 디테일 표현 등을 언급했습니다. 실제로 A11의 ISP는 머신러닝 기반 이미지 처리를 염두에 두고 설계되어, 같은 칩의 뉴럴 엔진과 협업하여 사진을 보정하는 컴퓨테이셔널 사진 기능들을 지원했습니다. 예를 들어 아이폰 X 및 8 플러스에서 도입된 인물 조명(Portrait Lighting) 효과는 ISP가 실시간으로 얼굴을 인식하고 깊이를 계산한 결과를 활용하여 조명을 시뮬레이션하는 기능인데, 이는 ISP의 빠른 처리와 iOS 소프트웨어의 결합으로 구현되었습니다.

2018년 A12 Bionic에서는 스마트 HDR이 도입되어, ISP가 매우 짧은 시간에 서로 다른 노출의 사진 여러 장을 촬영하고 뉴럴 엔진이 이를 합성하여 밝은 부분과 어두운 부분 모두 디테일이 살아있는 사진을 만들어냈습니다. 2019년 A13 Bionic에서는 딥 퓨전(Deep Fusion) 기술이 추가되어, ISP가 촬영한 다수의 프레임을 뉴럴 엔진이 픽셀 단위로 분석·결합함으로써 저중광에서 텍스처와 디테일을 극대화했습니다. 2020년 A14에서는 ISP가 업그레이드되어 Dolby Vision HDR 비디오 녹화(10비트 HDR)까지 스마트폰 최초로 가능해졌고, 2021년 A15에서는 개선된 ISP로 포토닉 엔진이라 불리는 이미지 처리 파이프라인을 선보여 저조도 사진 품질을 한층 높였습니다.

Apple ISP의 강점은 하드웨어-소프트웨어 최적화에 있습니다. 애플은 카메라 센서, 렌즈, ISP, 그리고 사진 앱의 소프트웨어까지 엔드투엔드로 설계를 통제하기 때문에, 노이즈 억제, 색 재현, HDR 합성 등이 매우 균형잡히고 자연스럽게 이루어집니다. 예를 들어 아이폰은 여러 카메라 간 색상 및 노출 매칭이 잘 되어 있어, 줌을 전환할 때 이질감이 거의 없습니다. 이는 하드웨어적으로는 단일 ISP 파이프라인에서 다중 센서 입력을 지능적으로 스케줄링하고, 소프트웨어적으로는 각 카메라의 특성을 보정하는 애플의 통합 접근 덕분입니다. 또한 애플은 뉴럴 엔진을 적극 활용해 장면 인식 및 분류, 피사체 분리(예: 인물 vs 배경), 얼굴 인식 기반 노출 제어 등을 수행하고, 그 결과를 ISP 처리에 반영합니다. 이러한 Semantic Rendering(의미 기반 렌더링) 기법을 통해, 예를 들어 하늘 영역은 톤매핑을 다르게 적용하고 인물 피부는 디테일을 보존하는 등 세밀한 최적화가 가능합니다. 결론적으로 Apple의 ISP 아키텍처는 최고 화질을 위해 특정 시나리오별 미세 조정까지 수행하며, 이는 소프트웨어와의 긴밀한 조합으로 구현되고 있습니다.

Samsung의 ISP 발전 (Exynos 및 이미지센서)

삼성은 Exynos 모바일 프로세서와 자체 이미지 센서(ISOCELL) 양쪽 분야에서 카메라 기술을 발전시켜왔습니다. 삼성의 Exynos SoC에는 초기부터 코덱, 디스플레이 엔진과 함께 ISP가 통합되었으며, 갤럭시 스마트폰의 카메라 성능 향상과 발맞춰 ISP 사양도 꾸준히 상승했습니다. 예를 들어 2014년 Exynos 5430은 1600만 화소 카메라와 2160p(4K) 영상 촬영을 지원했고, 2016년 Exynos 8890 (Galaxy S7)은 듀얼 픽셀 PDAF 센서를 활용한 빠른 AF와 멀티프레임 노이즈 감소 등 향상된 저조도 촬영을 구현했습니다. 2017년 Exynos 8895에서는 앞서 언급했듯이 전후면 28MP 카메라 처리 및 듀얼 카메라 지원이 추가되었고, 동영상도 4K 60fps까지 처리 가능해졌습니다. 이때부터 삼성 ISP도 듀얼 ISP 구조로 진화하여, 하나의 ISP로는 초고화소 센서를 지원하고 다른 ISP로는 보조 카메라를 동시에 구동하는 식의 운용이 가능했습니다.

삼성은 고화소 이미지 센서 분야를 선도하면서, 이를 처리할 ISP 기술을 함께 발전시킨 점이 특징입니다. 2019년 삼성은 세계 최초로 1억 800만 화소(108MP) 모바일 센서를 발표했고, 이를 지원하기 위해 2020년 Exynos 990 및 2021년 Exynos 2100 등의 ISP는 단일 센서로 최대 200MP까지 입력을 받을 수 있도록 설계되었습니다. Exynos 2100의 ISP는 최대 6개의 개별 센서를 연결하고 그 중 4개까지 동시 구동할 수 있는 매우 유연한 구조로, 이는 삼성이 생각하는 다중 카메라 시스템 (예: 광각, 초광각, 망원, 심도 센서 등)의 확장성을 고려한 것입니다. 또한 삼성 ISP는 스마트 WDR(와이드다이내믹레인지), 실시간 객체 인식 등의 기능을 포함하며, 이는 삼성 이미지센서의 인터레브드 HDR 출력과 연계되어 HDR 사진/영상 품질을 높입니다.

삼성의 차별점은 자체 센서와 ISP의 조합 최적화 및 고해상도 처리입니다. 예를 들어 갤럭시 S 시리즈에서는 고화소 센서의 신호를 ISP에서 픽셀 비닝(인접 픽셀 합산)하여 밝고 선명한 결과를 얻는데, 이때 센서와 ISP 간 데이터 처리량을 최적화하여 실시간으로 1억 화소 이미지를 처리할 수 있습니다. 또한 삼성은 전문가 모드 등 사용자가 RAW 데이터를 활용할 수 있는 기능을 제공하면서, ISP 단계에서 기본 보정(렌즈 보정, 노이즈 억제 등)을 거친 고품질의 준-RAW 출력을 가능케 했습니다. 최근에는 엑시노스 SoC에 NPU(신경망 처리 장치)를 탑재하여, 사진 촬영 시 장면 최적화나 야간 모드에서 NPU가 처리한 결과(예: 노이즈 프로파일 평가)를 ISP 튜닝에 반영하는 구조로 진화하고 있습니다. 요약하면 Samsung의 ISP 아키텍처는 멀티센서 지원의 유연성, 초고화소 센서 데이터 처리, 센서-프로세서 간 최적화에 강점을 가지며, 이는 삼성의 모바일 카메라가 다양한 촬영 모드와 최고 화소 스펙을 갖추는 기반이 되고 있습니다.

Qualcomm vs Apple vs Samsung 요약 비교

- 통합 시기: Qualcomm은 2000년대 초 가장 먼저 통합 ISP를 선보였고, Apple은 2010년대 초 자사 SoC에 ISP를 포함 (초기에는 비공개적으로), Samsung도 비슷한 시기 자체 ISP를 탑재하기 시작.

- 아키텍처: Qualcomm은 일찍부터 듀얼/트리플 ISP로 병렬 처리에 집중했고, Apple은 단일 ISP이지만 SoC 내 전반적 통합 최적화로 멀티센서 지원, Samsung은 듀얼 ISP 기반에 센서 유연성 극대화.

- 컴퓨테이셔널 사진: Apple은 소프트웨어와 뉴럴엔진 활용이 뛰어나고 결과물의 자연스러움이 강점. Qualcomm은 강력한 DSP와 ISP로 실시간 처리량이 높고 AI 엔진으로 3A 향상. Samsung은 고화소 HDR 처리 등 센서 성능 극대화에 주력.

- 차별화 기능: Apple – Deep Fusion, Smart HDR 등의 높은 완성도 합성; Qualcomm – 3개 카메라 동시 4K 촬영, AI AutoFocus 등; Samsung – 108MP 비닝촬영, 다중센서 연계 촬영 등.

이처럼 세 회사의 ISP는 각자의 모바일 기기 전략에 맞춰 발전해왔지만, 결과적으로 공통적으로 추구하는 방향은 더 높은 화질, 빠른 처리, 다중카메라 지원, AI와의 융합으로 수렴되고 있습니다.

ISP 아키텍처 구성 요소와 블록 다이어그램

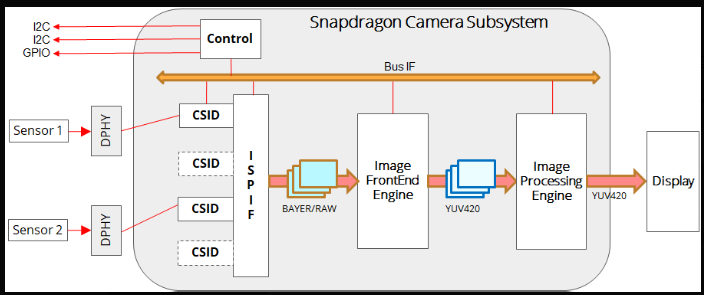

현대 ISP 내부는 복잡한 파이프라인으로 구성되어 있으며, 여러 하드웨어 블록들이 연속적으로 이미지 신호를 처리합니다. 아래 다이어그램은 스마트폰 카메라 서브시스템의 블록 구성 예시로, 센서 입력부터 디스플레이/메모리로 출력되기까지 ISP의 주요 모듈을 나타냅니다.

Snapdragon 카메라 서브시스템 블록 다이어그램 예시.

위 그림에서 보듯이, 두 개의 이미지 센서가 MIPI CSI-2 인터페이스(DPHY 물리계층을 통해)로 ISP에 연결되고, CSID(Camera Serial Interface Decoder) 모듈에서 센서의 Bayer Raw 데이터를 수신합니다. 그런 다음 데이터가 ISP 입출력(IF) 및 버스 인터페이스를 통해 내부 처리 엔진으로 전달됩니다. ISP 내부는 크게 전처리(Image Front End, IFE) 단계와 후처리(Image Processing Engine, IPE) 단계로 나눌 수 있습니다. IFE 블록에서는 베이어 도메인에서의 1차 처리, 즉 렌즈 보정, 색깔 균형, 3A 통계 등이 이루어지며, 여기서 디모자이킹을 거쳐 YUV 등 중간 포맷으로 변환된 영상이 생성됩니다. 이어서 IPE 블록에서는 노이즈 감소, 색보정, 감마 보정, 샤프닝 등 고품질 화상을 얻기 위한 후속 처리를 수행하고 최종 출력물(예: YUV 4:2:0 프레임)을 메모리나 디스플레이로 내보냅니다.

일반적인 ISP 파이프라인을 단계별로 정리하면 다음과 같습니다:

- 센서 인터페이스 입력: MIPI CSI-2 등을 통해 Bayer 패턴의 RAW 데이터 수신.

- 블랙 레벨 보정: 센서의 암전류에 의한 오프셋을 제거하여 검은색 기준을 맞춤.

- 젠즈 쉐이딩 보정: 이미지 가장자리의 비네팅(vignetting) 현상을 보정하여 화면 전체의 조도 균일화.

- 데드/핫 픽셀 교정: 불량 화소(항상 밝거나 항상 어두운 픽셀)를 주변 값으로 보간하여 제거.

- 3A 메타데이터 추출: 현재 프레임의 히스토그램, 밝기분포 등 AE/AWB/AF에 필요한 통계를 계산. (제어 알고리즘은 ISP 펌웨어 또는 SoC DSP가 수행하고, 결정된 노출/포커스/화이트밸런스 설정은 센서나 처리에 반영함).

- 디모자이킹(Demosaicing): Bayer 패턴의 단일 채널 데이터를 풀컬러 이미지로 복원. 각 화소의 주변 색 정보를 참고해 R, G, B 값을 할당하며, 엣지 보존 등을 위해 복잡한 보간 알고리즘 적용.

- 색 보정 및 화이트 밸런스: 센서 색공간에서 sRGB 등 목표 색공간으로 색변환 매트릭스를 적용하고, 조명에 따른 색온도 차이를 화이트밸런스 보정으로 제거. 이 단계에서 색 정확도가 결정됨.

- 노이즈 제거(Denoising): 고감도에서 발생하는 센서 잡음 및 디모자이킹 등에서 생긴 영상 노이즈를 억제. 공간적 필터링뿐 아니라, ZSL 버퍼나 연속 프레임을 이용한 타임돔레인 노이즈 감소(특히 동영상)도 수행.

- 고속/고해상도 처리: 멀티프레임 합성이 필요한 경우(예: HDR, 야간모드), 다중 노출 프레임을 버퍼에 저장하고 합성 알고리즘 수행. 또는 듀얼/트리플 카메라 입력 간 데이터 동기화 및 융합(fusion) 처리. (일부 ISP는 이를 위해 별도 HDR 합성 하드웨어나 딥러닝 가속기를 포함).

- 샤프닝 및 디테일 강화: 디모자이킹과 노이즈제거를 거친 영상은 다소 블러가 생길 수 있으므로, 가장자리 부분을 강조하는 이미지 샤프닝 필터를 적용. 오버슈트나 헤일로를 방지하는 정교한 알고리즘 사용.

- 감마 보정(Gamma Correction): 사람 눈에 맞는 밝기 표현을 위해 감마 곡선을 적용. 일반적으로 sRGB/Rec.709 표준 감마에 따라 중간톤 대비를 높여준다.

- 톤 맵핑(Tone Mapping) / HDR 처리: HDR 합성 결과나 명암 대비가 큰 이미지에 대해 국부 톤맵핑을 적용하여 밝은 부분과 어두운 부분의 디테일을 모두 살리는 작업. 이것은 이미지의 다이내믹 레인지를 출력 디스플레이에 맞게 압축하면서도 시각적으로 자연스럽게 보이도록 하는 단계이다.

- 리샘플링/리사이즈 및 크롭: 최종 출력 해상도로 스케일링하거나 원하는 화면 비율로 자르기. 예를 들어 센서 출력이 4:3 비율이라면 16:9 동영상 출력을 위해 상하 크롭. 또한 전자식 손떨림 보정(EIS)을 위해 주변부 여유를 두고 중앙 크롭하기도 함.

- 컬러 포맷 변환 및 출력: 내부 처리 영상은 RGB로 존재하지만, 저장이나 전송을 위해 YCbCr(YUV) 4:2:0 등으로 색 변환 후 압축(JPEG/HEIC)하거나 동영상 인코더로 전달. 최종적으로 메모리에 저장되거나 디스플레이에 실시간 뿌려지는 프레임이 된다.

위 단계들은 ISP마다 세부 구현과 순서에 차이가 있을 수 있지만, 디모자이킹 → 색보정/노이즈제거 → 샤프닝/감마 → 출력 포맷팅이라는 큰 흐름은 공통적입니다. 최신 ISP는 이러한 파이프라인을 유연하게 구성하여, 필요에 따라 일부 단계를 패스하거나(예: RAW 데이터 저장 시 디모자이킹/색보정 패스) 또는 별도 경로로 처리하기도 합니다. 예를 들어 병렬한 프리뷰 경로와 캡처 경로를 두어, 프리뷰 영상은 저해상도/저지연 처리하고 캡처용 정밀 처리는 별도로 더 강하게 적용하는 식입니다. 또한 하드웨어 HDR 합성 엔진, 얼굴/물체 인식용 부속 DSP, 왜곡 보정 전용 블록 등 특정 기능을 가속하는 모듈도 포함될 수 있습니다.

ISP 내부 알고리즘 및 주요 기술

앞서 블록 다이어그램에서 언급된 각 처리 단계에서는 다양한 신호 처리 알고리즘이 사용됩니다. 아래에서는 ISP에서 핵심적으로 수행되는 알고리즘들을 개괄합니다:

디모자이킹 (Demosaicing)

디모자이킹은 센서의 베이어 패턴(Bayer pattern)으로부터 풀컬러 이미지를 복원하는 알고리즘입니다. 이미지 센서의 각 화소는 빨강, 초록, 파랑 중 한 색의 정보만 기록하므로, 인접 픽셀들의 색값을 조합해 보간함으로써 R,G,B 세 채널의 이미지를 생성해야 합니다. 초기 디모자이킹은 단순 선형 보간(예: 빌리니어) 방법이 사용되었으나, 이 경우 대각선 줄무늬 등 모아레(moiré)와 색번짐(color fringing) 아티팩트가 발생하기 쉬웠습니다. 현대 ISP에서는 에지(edge) 인식 보간, 향상된 그린 채널 보간 등 복잡한 알고리즘을 사용하여 해상도를 높이고 격자 무늬 등 인공물을 줄입니다. 디모자이킹 품질은 사진의 디테일과 색 정확도에 큰 영향을 미치므로, 각 업체는 최적화된 자체 알고리즘을 탑재합니다. (일부 최신 접근으로 딥러닝 기반 디모자이킹도 연구되고 있으나, 실시간 임베디드 구현에는 제약이 있습니다.)

노이즈 감소 (Denoising)

노이즈는 센서 및 회로에서 기인하는 무작위 신호로서, 주로 어두운 환경이나 고ISO 감도에서 이미지에 잔뜩 얼룩이나 점 형태로 나타납니다. ISP에서는 이러한 노이즈를 최소화하면서 디테일은 유지하는 노이즈 감소 알고리즘이 중요합니다. 대표적으로 공간적 노이즈 감소는 주변 픽셀들의 밝기 값을 분석해 이상치를 완화시키는 필터(예: 밴릴로 또는 웨이블렛 기반 필터)를 사용합니다. 또한 동영상이나 연속촬영의 경우 시간적 노이즈 감소를 위해 연속 프레임 간 픽셀 값을 비교하여 일정 패턴으로 남는 노이즈를 제거하고 디테일은 보존하는 알고리즘이 쓰입니다. 최신 스마트폰은 여러 장의 사진을 촬영한 후 합성하여 노이즈를 줄이는 멀티프레임 NR도 활용합니다. 예를 들어 어두운 장면에서 10장의 이미지를 촬영해 평균내면 무작위 노이즈는 줄어들고 신호는 강화되는 원리로, Google의 HDR+나 애플의 야간 모드 등이 이런 개념을 응용했습니다. ISP 하드웨어도 이러한 다중 프레임 노이즈 억제를 가속할 수 있도록 설계되며, 퀄컴 Snapdragon ISP는 프레임 버퍼 메모리와 고속처리를 통해 초당 수십장의 이미지를 합성할 수 있습니다. 한편 노이즈 감소 시 지나치면 디테일이 뭉개지는 과평활(Over-smoothing) 문제가 발생하므로, 현대 ISP는 디테일 추출 알고리즘(에지 보존)과 노이즈 모델링 기법을 도입해 적응적으로 필터 강도를 조절합니다.

화이트 밸런스 (AWB) 및 색 보정

자동 화이트 밸런스(AWB)는 다양한 조명 아래에서 중립적인 백색을 재현하기 위한 알고리즘입니다. 햇빛, 형광등, LED 등 광원에 따라 색온도와 스펙트럼이 달라지는데, 이는 사진 전체의 색조에 영향을 미칩니다. ISP는 이미지 통계를 통해 현재 장면의 색 편차를 추정하고 R, G, B 채널에 각각 게인(gain)을 적용하여 중간 계조의 색이 회색 또는 백색이 되도록 보정합니다. 예컨대 실내 조명(주황색 조명)에서는 파란 채널 게인을 높여 전체적으로 노란끼를 빼주는 식입니다. 과거에는 이미지의 평균 RGB값이나 그레이 월드를 가정한 간단한 방식으로 AWB를 했지만, 현대 AWB는 장면 인식과 머신러닝을 이용하여 보다 정확히 수행됩니다. 예를 들어 딥러닝 AWB는 이미지 내용을 분석해 인물 피부톤이나 하늘색 등을 인지하고, 사람이 보기 좋은 색이 되도록 보정합니다. 또한 AWB와 연계하여 색 보정(Color Correction) 매트릭스를 적용하는데, 이는 센서 색 공간에서 표준 RGB 색 공간으로 변환하는 3x3 행렬 연산입니다. 각 ISP는 자사 센서 특성에 맞춰 색 보정 행렬을 튜닝하며, 이를 통해 빨강/파랑 감도의 차이, 센서 필터의 스펙트럼 특성 등을 교정합니다. 종합적으로 AWB와 색 보정 단계에서 사진의 색 정확성과 분위기가 결정되며, 특히 스마트폰 제조사들은 자체 색감 튜닝 철학을 반영하여 다소 다르게 결과물이 나오기도 합니다 (예: 아이폰은 자연스럽고 차분한 색, 삼성 갤럭시는 다소 쨍하고 선명한 색 등).

감마 보정 (Gamma Correction)

감마 보정은 디스플레이 또는 인간의 시각 특성에 맞게 밝기 값을 조정하는 과정입니다. 센서가 출력하는 원본 신호는 선형(linear) 관계이지만, 인간의 눈은 어두운 영역의 변화에 민감하고 밝은 영역 변화에는 둔감한 특성이 있습니다. 따라서 이미지의 RGB 값에 감마 곡선(보통 0.45 정도의 감마)을 적용하여, 원본 대비 중간 밝기 톤을 더 띄워줍니다. 이를 통해 그림자의 디테일이 더 보이고, 하이라이트는 포화되지 않도록 조정됩니다. 감마 보정은 일종의 명암 대비 조절로 볼 수 있으며, 일반적으로 sRGB 표준 감마를 따른 결과가 JPEG 등에 저장됩니다. 감마 보정 단계는 비교적 간단한 룩업 테이블(LUT) 처리를 하며, ISP는 10비트 이상 내부 정밀도로 계산하여 감마로 인한 밴딩 현상을 최소화합니다. 또한 사진 스타일에 따라 감마 곡선을 변형시키기도 하는데, 이를 톤 커브 조정이라고도 부릅니다. 예를 들어 콘트라스트를 높이고 싶으면 감마 곡선을 S-자 형태로 조정하여 어두운 곳은 더 어둡게, 밝은 곳은 더 밝게 표현합니다.

톤 매핑 및 HDR 합성 (Tone Mapping & HDR)

톤 매핑(Tone mapping)은 HDR(High Dynamic Range) 이미지를 LDR(Low Dynamic Range) 디스플레이에 표현하기 위한 핵심 알고리즘입니다. 일반 카메라 사진은 센서 한계로 인해 밝은 하늘을 찍으면 어두운 지형은 까맣게 나오고, 어두운 실내를 찍으면 창밖이 새하얗게 날아가는 문제가 있습니다. HDR 합성은 이러한 문제를 해결하기 위해 서로 다른 노출로 촬영된 이미지를 결합하여 어두운 곳과 밝은 곳 모두 정보가 남아있게 만드는 기술입니다. ISP 단계에서 HDR을 구현하는 전통적 방식은 노출 브라케팅 기법으로, 예를 들어 -2EV, 0EV, +2EV로 촬영된 3장의 사진을 정렬 및 합성합니다. 현대 ISP는 센서의 지원 하에 실시간 HDR을 수행하는데, 앞서 언급된 스태거드 HDR 센서의 출력으로 3개의 노출 프레임이 한 프레임 시간에 얻어지면 이를 ISP가 바로 합쳐서 하나의 HDR 이미지를 만듭니다. 합성 시에는 픽셀 단위로 가중합이나 최적 픽셀 선택 등이 이뤄지며, Qualcomm 등은 이를 위해 전용 회로 및 알고리즘(예: Local Tone Mapping)을 탑재했습니다.

HDR 합성 후에 필수적인 단계가 톤 매핑입니다. 합성 결과 HDR 이미지는 14비트 이상의 매우 넓은 다이내믹 레인지를 갖지만, 우리가 보는 디스플레이는 8~10비트 정도이므로 이를 압축해야 합니다. 단순히 선형 압축하면 밋밋한 이미지가 되므로, Adaptive Tone Mapping(ATM)이나 Local Tone Mapping(LTM) 알고리즘을 통해 국부 대비를 살리는 과학적인 조정이 필요합니다. 예를 들어 밝은 하늘과 어두운 숲이 함께 있는 사진에서, 전체적으로 중간값으로 맞추면 평坦해지기 때문에, 하늘은 하늘대로, 숲은 숲대로 콘트라스트를 조정하는 방식입니다. 이를 위해 이미지를 타일이나 영역으로 나눠 각각 다른 톤 커브를 적용합니다. 현대 ISP는 이러한 지역별 톤매핑을 실시간으로 수행하며, 그 결과 눈으로 보기에도 디테일이 풍부하면서도 과하지 않은 HDR 사진이 얻어집니다. 참고로 최신 스마트폰에서는 HDR 합성에 뉴럴넷을 활용하기도 하는데 (예: 머신러닝으로 노출 합성 최적화), 기본 아이디어는 위와 비슷하되 품질을 더 높이기 위한 접근입니다.

기타 최신 이미지 개선 기술 (AI 기반 보정 등)

오늘날 ISP에는 전통적 신호처리 외에도 AI 기반 이미지 개선 기법이 속속 도입되고 있습니다. 대표적인 예로 장면 인식(Scene Detection)이 있습니다. 카메라가 현재 장면이 인물사진인지, 풍경인지, 음식 사진인지 등을 AI로 분류한 뒤, 그에 맞게 색감이나 샤프니스 등을 조정하는 것입니다. 삼성, 화웨이 등의 Scene Optimizer 기능은 이러한 개념으로, 예를 들어 음식은 색을 조금 더 강렬하게, 문서는 대비를 높게, 하늘은 더 파랗게 보정합니다. 이러한 조정은 ISP 이후 소프트웨어 단계에서 이루어지기도 하지만, AI 연산이 ISP 내에 통합되어 실시간 프리뷰에 반영되기도 합니다.

또 다른 기술로 멀티프레임 초해상도가 있습니다. 구글 Pixel이 선보인 Super Res Zoom은 여러 연속샷을 미세하게 다른 각도로 촬영한 후 합쳐서 디지털 줌 상태에서도 해상도를 높이는 기술인데, 최신 ISP들은 이러한 다중 프레임 정합 및 합성을 가속하여 줌 품질을 향상시키고 있습니다. Morpho사의 AutoZoom이나 퀄컴의 AI 기반 줌 기능은 피사체를 추적하면서 프레임들을 적절히 합성해주기도 합니다.

왜곡 보정 및 울트라와이드 처리도 중요한 최신 기술입니다. 초광각 렌즈는 왜곡이 심하고 주변부 해상도 저하가 있는데, ISP는 왜곡 보정 알고리즘을 통해 이미지의 기하학적 왜곡을 실시간 수정합니다. 또한 주변부 선명도를 높이기 위해 지역별 샤프닝 강도를 다르게 하거나, 색수차 보정 등을 수행합니다. 전에는 PC 소프트웨어로 하던 이런 작업들을 이제는 ISP가 바로 처리하여 사용자에게 완성된 결과물을 제공합니다.

마지막으로, 안전과 보안 측면에서 콘텐츠 진위 확인을 위한 메타데이터 삽입 기능 등이 최근 도입되었습니다. 예를 들어 Snapdragon 888 ISP는 CAI(Content Authenticity Initiative) 규격에 맞춰 촬영된 이미지에 암호학적 서명을 부여해 이후 변경 여부를 판별할 수 있도록 하는 기능을 갖추고 있습니다. 이는 딥페이크나 이미지 조작이 문제시되는 시대에, 원본 사진의 신뢰성을 보장하기 위한 첨단 기능이라 할 수 있습니다.

'System-on-Chip Design' 카테고리의 다른 글

| 클럭 트리 삽입 (Clock Tree Insertion) (0) | 2025.03.01 |

|---|---|

| Clock Sources, PLL and Clock Trees (0) | 2025.03.01 |

| 동적 클럭 게이팅 (Dynamic Clock Gating) (0) | 2025.03.01 |

| 시스템 반도체 설계를 위한 SysML 기반의 기능 분석 (2) | 2025.02.22 |

| SERDES(Serializer/Deserializer)의 개념, 아키텍처, 그리고 응용 분야 (2) | 2025.02.20 |