DGX H100 SERVER 상세 분석

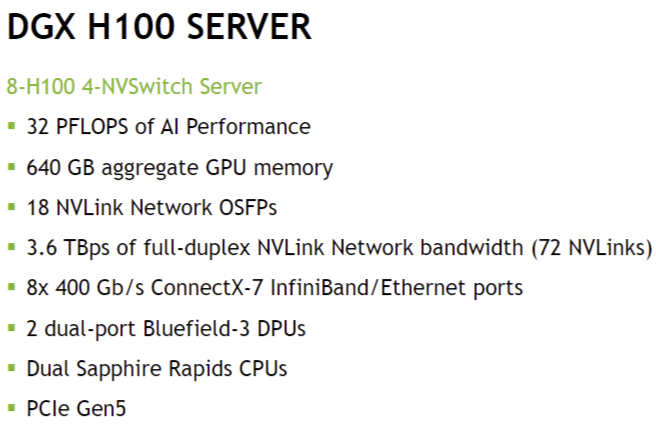

DGX H100 서버는 AI, 딥러닝, 고성능 컴퓨팅(HPC) 환경에서 사용되는 최첨단 GPU 서버로,

최대 32 PFLOPS(PetaFLOPS)의 AI 성능과 초고속 NVLink 및 InfiniBand 네트워크를 지원합니다.

1. DGX H100 서버 개요

- 8개의 H100 GPU 및 4개의 NVSwitch로 구성된 고성능 AI 서버

- 3.6TB/s NVLink 대역폭을 활용하여 GPU 간 빠른 데이터 전송 가능

- InfiniBand 및 BlueField-3 DPU(Data Processing Unit)를 활용한 네트워크 최적화

- PCIe Gen5 지원으로 CPU-GPU 및 GPU-GPU 간 데이터 전송 속도 향상

- Intel Sapphire Rapids CPU를 탑재하여 강력한 연산 및 데이터 처리 성능 제공

2. DGX H100 서버 주요 사양 설명

사양설명

| 8-H100 4-NVSwitch Server | 8개의 NVIDIA H100 GPU와 4개의 NVSwitch로 구성된 서버 |

| 32 PFLOPS of AI Performance | 32 PetaFLOPS(= 32×10¹⁵ FLOPS)급 AI 연산 성능 (FP16 Tensor Core) |

| 640 GB aggregate GPU memory | 8개의 H100 GPU가 각각 80GB의 HBM3 메모리를 제공하여 총 640GB |

| 18 NVLink Network OSFPs | 18개의 NVLink 네트워크 포트(Optical Small Form-factor Pluggable) |

| 3.6 TBps full-duplex NVLink Network bandwidth (72 NVLinks) | NVSwitch를 통한 72개의 NVLink 연결로 3.6TB/s의 양방향 데이터 전송 가능 |

| 8x 400 Gb/s ConnectX-7 InfiniBand/Ethernet ports | 8개의 400Gb/s 포트를 통해 InfiniBand 및 이더넷 네트워크 연결 가능 |

| 2 dual-port BlueField-3 DPUs | BlueField-3 DPU(데이터 처리 유닛) 2개 포함 (각각 듀얼 포트) |

| Dual Sapphire Rapids CPUs | Intel Xeon Sapphire Rapids CPU 2개 탑재 |

| PCIe Gen5 | 최신 PCIe 5.0 인터페이스 지원, GPU-CPU 및 스토리지 전송 속도 향상 |

3. 주요 용어 및 개념 설명

(1) H100 GPU

- NVIDIA의 최신 AI/HPC용 GPU 아키텍처 (Hopper 기반)

- FP16 Tensor Core 성능으로 최대 32 PFLOPS의 연산 수행 가능

- HBM3 메모리(High Bandwidth Memory 3) 사용으로 높은 메모리 대역폭 제공

- NVLink 4.0을 지원하여 GPU 간 초고속 데이터 전송 가능

(2) NVSwitch & NVLink Network

- NVLink: NVIDIA의 GPU 간 초고속 데이터 인터커넥트 기술

- NVSwitch: 여러 개의 NVLink를 연결하여 멀티-GPU 환경에서 데이터 전송 최적화

- DGX H100 서버는 72개의 NVLink를 사용하여 GPU 간 3.6TB/s 대역폭 제공

- 18개의 OSFP(Optical Small Form-factor Pluggable) 포트를 통해 NVLink 네트워크 확장 가능

(3) PFLOPS (PetaFLOPS)

- PFLOPS(Peta Floating Point Operations Per Second): 초당 10¹⁵ 회의 부동소수점 연산을 수행하는 성능 단위

- DGX H100 서버는 32 PFLOPS로, AI 모델 학습 및 추론 속도가 매우 빠름

(4) 640GB GPU 메모리

- 8개의 H100 GPU가 각각 80GB의 HBM3 메모리를 제공하여 총 640GB

- HBM3(High Bandwidth Memory 3) 사용으로 기존 GDDR6보다 높은 대역폭 제공

- AI 모델 학습 시 대규모 파라미터 및 데이터셋을 GPU 메모리에 직접 저장하여 속도 향상

(5) ConnectX-7 InfiniBand/Ethernet

- 8개의 400Gb/s InfiniBand 또는 이더넷 포트 제공

- InfiniBand는 초고속 RDMA(Remote Direct Memory Access) 지원

- GPU 및 스토리지 간 고속 데이터 전송을 위해 사용됨

- ConnectX-7는 최신 InfiniBand 네트워크 어댑터로, 지연 시간 최소화 및 높은 대역폭 제공

(6) BlueField-3 DPU (Data Processing Unit)

- BlueField-3는 NVIDIA의 최신 DPU(Data Processing Unit)

- 서버의 네트워크 및 데이터 처리 부하를 줄이기 위해 사용

- AI 학습 데이터 이동 및 보안 프로세싱을 최적화

- 듀얼 포트로 구성되어 있어 네트워크 병목을 줄이고 효율적인 데이터 전송 가능

(7) Dual Sapphire Rapids CPUs

- Intel Xeon Sapphire Rapids 프로세서 2개 포함

- 4세대 Xeon 스케일러블 프로세서로, 고성능 컴퓨팅 및 AI 워크로드 지원

- PCIe Gen5 및 DDR5 지원으로 높은 대역폭 제공

- DGX 서버에서 CPU는 GPU의 보조 역할을 하며, 데이터 전처리 및 네트워크 관리 수행

(8) PCIe Gen5

- PCI Express 5.0 지원 (x16 슬롯 기준 최대 128GB/s 대역폭)

- GPU와 CPU 간 데이터 전송 속도를 크게 향상

- 스토리지(NVMe SSD) 및 네트워크 장비와의 연결 속도 증가

4. DGX H100 서버의 활용 분야

(1) AI 모델 학습 및 추론

- 초거대 AI 모델(GPT, BERT, DALL·E) 학습 최적화

- DGX H100 서버는 8개의 H100 GPU를 활용하여 분산 학습 수행

- NVLink 및 NVSwitch를 통해 GPU 간 대규모 데이터 교환 속도를 극대화

- AI 추론 시 최대 32 PFLOPS 성능을 활용하여 빠른 응답 시간 제공

(2) 고성능 컴퓨팅 (HPC)

- 물리 시뮬레이션, 기후 예측, 유전체 분석 같은 HPC(High-Performance Computing) 작업에 최적

- InfiniBand 및 NVLink를 활용한 고속 데이터 전송으로 슈퍼컴퓨터 수준의 성능 제공

- AI 기반 과학 연구(신약 개발, 양자 시뮬레이션 등) 지원

(3) 금융 및 클라우드 데이터센터

- 금융 모델링, 실시간 리스크 분석, 초고속 금융 거래(HFT, High-Frequency Trading)

- BlueField-3 DPU를 활용하여 보안 및 네트워크 성능 향상

- 클라우드 AI 서비스 제공을 위한 대규모 데이터센터 구축 가능

5. 결론

DGX H100 서버는 최첨단 AI 및 HPC 연산을 위한 초고성능 GPU 서버입니다.

- 8개의 H100 GPU와 4개의 NVSwitch로 구성된 강력한 AI 컴퓨팅 노드

- NVLink 및 NVSwitch를 활용하여 GPU 간 3.6TB/s 초고속 데이터 전송 가능

- BlueField-3 DPU 및 InfiniBand 400Gb/s를 통한 네트워크 최적화

- Intel Xeon Sapphire Rapids CPU 및 PCIe Gen5 지원으로 최신 하드웨어와 연동 가능

- AI 학습, 추론, HPC, 금융 분석 등 다양한 워크로드에 적합

즉, DGX H100 서버는 초거대 AI 모델 학습 및 고성능 컴퓨팅 환경에서 최적의 성능을 제공하는 NVIDIA의 최신 플래그십 AI 서버입니다.

NVIDIA H100 GPU: 차세대 AI 및 HPC용 최첨단 GPU

H100은 NVIDIA Hopper 아키텍처 기반의 최신 데이터센터용 GPU로,

AI, 딥러닝, 고성능 컴퓨팅(HPC), 클라우드, 금융 연산 등 다양한 분야에서 사용됩니다.

기존의 A100(Ampere 아키텍처) 대비 대폭적인 성능 향상을 제공하며,

FP8 Tensor Core, Transformer Engine, NVLink4, PCIe Gen5 등의 최신 기술을 포함하고 있습니다.

1. NVIDIA H100 GPU의 핵심 사양

스펙 항목H100 SXM5H100 PCIe

| 아키텍처 | Hopper | Hopper |

| 프로세스 노드 | TSMC 4N (TSMC 4nm 공정) | TSMC 4N |

| 트랜지스터 개수 | 80B (800억 개) | 80B |

| FP8 Tensor Core 성능 | ~ 4 PFLOPS | ~ 2 PFLOPS |

| FP16 Tensor Core 성능 | 2 PFLOPS | 1 PFLOPS |

| FP64 연산 성능 | 60 TFLOPS | 30 TFLOPS |

| CUDA 코어 개수 | 16896개 | 14592개 |

| Tensor 코어 개수 | 528개 | 456개 |

| HBM3 메모리 용량 | 80GB | 80GB |

| 메모리 대역폭 | 3.35TB/s | 2TB/s |

| NVLink 대역폭 | 900GB/s | 600GB/s |

| 인터페이스 | NVLink4 + PCIe Gen5 | PCIe Gen5 |

| TDP (소비전력) | 700W | 350W |

SXM5 모델이 PCIe 모델보다 더 강력한 성능과 높은 대역폭을 제공하며, 데이터센터에서 멀티-GPU 연결에 최적화되어 있음.

2. H100의 주요 기술 및 특징

(1) Hopper 아키텍처 (Hopper Architecture)

- Ampere(A100) 대비 대폭적인 성능 향상

- 4nm(TSMC 4N) 공정으로 전력 효율 최적화

- 2세대 NVLink4 지원 (900GB/s 대역폭 제공)

(2) Transformer Engine

- 대규모 AI 모델(예: GPT-4, BERT, DALL·E) 최적화

- FP8 연산을 지원하여 기존 FP16 대비 2배 높은 성능 제공

- 딥러닝 트레이닝 및 추론 속도를 획기적으로 향상

(3) FP8 Tensor Core

- 기존 Ampere(A100)의 FP16 Tensor Core 대비 2배 높은 성능 제공

- FP8(부동소수점 8비트) 연산을 통해 AI 학습 속도를 극대화

- 4 PFLOPS의 AI 연산 성능 지원 (SXM5 기준)

(4) HBM3 메모리 (High Bandwidth Memory 3)

- 80GB의 HBM3(High Bandwidth Memory 3) 탑재

- 메모리 대역폭 3.35TB/s (A100 대비 50% 이상 증가)

- 초거대 AI 모델 및 HPC 워크로드에 최적화된 메모리 구조

(5) NVLink4 및 NVSwitch 지원

- NVLink 4.0을 통해 GPU 간 최대 900GB/s의 데이터 전송 가능

- NVSwitch와 연결하면 여러 개의 H100 GPU를 초고속 네트워크로 묶을 수 있음

- 대규모 AI 모델 학습 시 GPU 간 데이터 전송 속도 병목을 해결

(6) PCIe Gen5 지원

- 최신 PCI Express 5.0 인터페이스 지원

- 기존 PCIe Gen4 대비 2배 높은 대역폭 제공

- CPU와의 데이터 전송 속도 증가 (메모리 및 스토리지와 빠른 연결 가능)

(7) DPX(Dynamic Programming eXecution) 가속

- 동적 프로그래밍 기반의 최적화 문제를 GPU에서 가속

- 예: 유전자 분석, 생명과학, 경로 탐색, 그래프 알고리즘 가속

- CPU 대비 최대 40배 빠른 처리 속도 제공

3. H100 vs. A100 성능 비교

항목H100 SXM5A100 SXM4성능 향상

| FP8 Tensor Core | 4 PFLOPS | 지원 안 함 | 🚀 2배 이상 |

| FP16 Tensor Core | 2 PFLOPS | 1 PFLOPS | 🚀 2배 |

| FP64 연산 성능 | 60 TFLOPS | 20 TFLOPS | 🚀 3배 |

| CUDA 코어 개수 | 16896개 | 6912개 | 🚀 2.4배 |

| HBM 메모리 대역폭 | 3.35TB/s | 1.55TB/s | 🚀 2배 이상 |

| NVLink 대역폭 | 900GB/s | 600GB/s | 🚀 1.5배 |

| TDP(전력 소비) | 700W | 400W | 📈 증가 |

H100은 A100 대비 AI, HPC 성능이 2~3배 이상 향상되었으며, FP8 지원 및 메모리 대역폭이 크게 증가하여 초거대 AI 모델 학습에 최적화됨.

4. H100의 활용 분야

(1) AI/딥러닝 모델 학습 및 추론

- GPT-4, BERT, Stable Diffusion 같은 초거대 AI 모델 학습

- FP8 Tensor Core 및 Transformer Engine을 활용하여 연산 속도 극대화

- 대규모 언어 모델(LLM) 및 생성형 AI 워크로드에 최적

(2) 고성능 컴퓨팅 (HPC)

- 양자 시뮬레이션, 기후 예측, 유전자 분석, 물리 시뮬레이션

- FP64 연산 성능(60 TFLOPS)으로 HPC 워크로드 가속화

- InfiniBand 및 NVLink를 활용하여 GPU 클러스터 확장 가능

(3) 데이터센터 및 클라우드 AI

- Amazon AWS, Microsoft Azure, Google Cloud에서 H100 기반 AI 서비스 제공

- 대규모 데이터 분석 및 금융 모델링 처리 가능

- 데이터센터 효율성을 극대화하는 고성능 GPU

(4) 금융 및 생명과학

- 유전자 분석, 신약 개발, 금융 모델링 최적화

- DPX 기능을 통해 최적화 문제를 CPU보다 최대 40배 빠르게 해결

5. 결론

H100은 AI, 딥러닝, 고성능 컴퓨팅(HPC)을 위한 NVIDIA의 차세대 GPU로,

기존 A100 대비 2~3배 향상된 성능과 FP8 Tensor Core, HBM3, NVLink4 등의 최신 기술을 갖춘 최고의 데이터센터 GPU입니다.

- AI 학습 및 HPC 연산 속도를 획기적으로 향상

- FP8 Tensor Core 및 Transformer Engine으로 초거대 AI 모델 최적화

- 900GB/s NVLink, 3.35TB/s HBM3 메모리 대역폭으로 대규모 데이터 처리 가능

- PCIe Gen5 및 DPX 가속을 통해 다양한 최적화 문제를 해결

- 데이터센터, 클라우드, 금융, 생명과학 등 다양한 산업에서 사용 가능

즉, H100은 AI 및 HPC의 미래를 이끄는 NVIDIA의 가장 강력한 GPU입니다.